USB é a sigla para Universal Serial Bus. Trata-se de uma tecnologia que tornou mais simples, fácil e rápida a conexão de diversos tipos de aparelhos (câmeras digitais, HDs externos, pendrives, mouses, teclados, MP3-players, impressoras, scanners, leitor de cartões, etc) ao computador, evitando assim o uso de um tipo específico de conector para cada dispositivo. Neste artigo, você verá as principais características dessa tecnologia, conhecerá os seus conectores, saberá um pouco de seu funcionamento e entenderá os motivos que levaram o USB a ser "presença obrigatória" em computadores e em vários outros dispositivos.

Surgimento do padrão USB

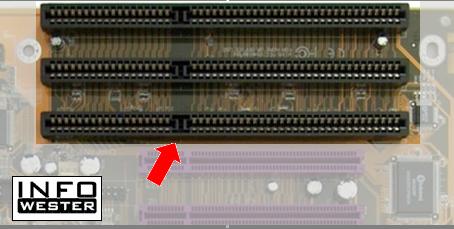

Antigamente, conectar dispositivos ao computador era uma tarefa pouco intuitiva, muitas vezes digna apenas de técnicos ou usuários com experiência no assunto. Para começar, diante de vários tipos de cabos e conectores, era necessário descobrir, quase que por adivinhação, em qual porta do computador conectar o dispositivo em questão. Quando a instalação era interna, a situação era pior, já que o usuário tinha que abrir o computador e quase sempre configurar jumpers e/ou IRQs. Somente de pensar em ter que encarar um emaranhado de fios e conectores, muitos usuários desistiam da ideia de adicionar um novo item à sua máquina.

Diante de situações desse tipo, a indústria entendeu a necessidade de criar um padrão que facilitasse a conexão de dispositivos ao computador. Assim, em 1995, um conjunto de empresas - entre elas, Microsoft, Intel, NEC, IBM e Apple - formou um consórcio para estabelecer um padrão. Surgia então o

USB Implementers Forum. Pouco tempo depois disso, as primeiras especificações comerciais do que ficou conhecido como Universal Serial Bus (USB) surgiram. A imagem ao lado mostra o símbolo da tecnologia.

Na verdade, a tecnologia já vinha sendo trabalhada antes mesma da definição do consórcio como USB Implementers Forum. As primeiras versões estabelecidas datam de 1994:

- USB 0.7: novembro de 1994;

- USB 0.8: dezembro de 1994;

- USB 0.9: abril de 1995;

- USB 0.99: agosto de 1995;

- USB 1.0: janeiro de 1996;

- USB 1.1: setembro de 1998;

- USB 2.0: abril de 2000.

As versões que entraram para uso comercial em larga escala foram a 1.1 e a 2.0, que serão vistas com mais detalhes neste texto.

Vantagens do padrão USB

Um dos principais motivos que levou à criação da tecnologia USB é a necessidade de facilitar a conexão de variados dispositivos ao computador. Sendo assim, o USB oferece uma série de vantagens:

- Padrão de conexão: qualquer dispositivo compatível como USB usa padrões definidos de conexão (ver mais no tópico sobre conectores), assim não é necessário ter um tipo de conector específico para cada aparelho;

- Plug and Play (algo como "Plugar e Usar"): quase todos os dispositivos USB são concebidos para serem conectados ao computador e utilizados logo em seguida. Apenas alguns exigem a instalação de drivers ou softwares específicos. No entanto, mesmo nesses casos, o sistema operacional reconhecerá a conexão do dispositivo imediatamente;

- Alimentação elétrica: a maioria dos dispositivos que usam USB não precisa ser ligada a uma fonte de energia, já que a própria conexão USB é capaz de fornecer eletricidade. Por conta disso, há até determinados dispositivos, como telefones celulares e MP3-players, que têm sua bateria recarregada via USB. A exceção fica por conta de aparelhos que consomem maior quantidade de energia, como scanners e impressoras;

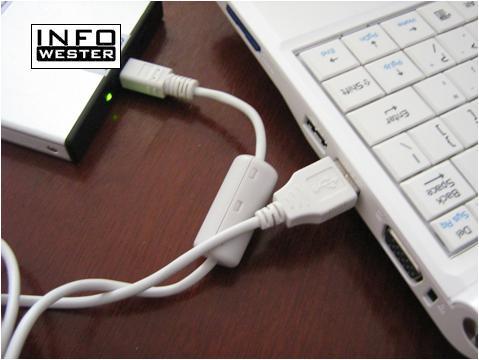

- Conexão de vários aparelhos ao mesmo tempo: é possível conectar até 127 dispositivos ao mesmo tempo em uma única porta USB. Isso pode ser feito, por exemplo, através de hubs, dispositivos que utilizam uma conexão USB para oferecer um número maior delas. Mas, isso pode não ser viável, uma vez que a velocidade de transmissão de dados de todos os equipamentos envolvidos pode ser comprometida. No entanto, com uma quantidade menor de dispositivos, as conexões podem funcionar perfeitamente;

- Ampla compatibilidade: o padrão USB é compatível com diversas plataformas e sistemas operacionais. O Windows, por exemplo, o suporta desde a versão 98. Sistemas operacionais Linux e Mac também são compatíveis. Atualmente, é possível encontrar portas USB em vários outros aparelhos, como televisores, sistemas de comunicação de carros e até aparelhos de som, como mostra a foto abaixo:

USB em um aparelho de som

USB em um aparelho de som

- Hot-swappable: dispositivos USB podem ser conectados e desconectados a qualquer momento. Em um computador, por exemplo, não é necessário reiniciá-lo ou desligá-lo para conectar ou desconectar o dispositivo;

- Cabos de até 5 metros: os cabos USB podem ter até 5 metros de tamanho, e esse limite pode ser aumentado com uso de hubs ou de equipamentos capazes de repetir os sinais da comunicação.

Sobre o funcionamento do USB

Como já informado, o barramento USB pode ser utilizado para prover energia elétrica a determinados dispositivos. Para que isso seja possível, os cabos USB contam com quatro fios internos: VBus (VCC), D+, D- e GND. O primeiro é o responsável pela alimentação elétrica. O segundo e o terceiro são utilizados na transmissão de dados (a letra "D" provém de data, dado em inglês). O quarto, por sua vez, é para controle elétrico, servindo como "fio-terra".

Vale frisar que, conforme dito no tópico anterior, os cabos USB devem ter, no máximo, 5 metros de comprimento. Isso é necessário porque, em cabos maiores, o tempo de transmissão dos dados pode exceder o limite de 1500 nanossegundos. Quando isso ocorre, a informação é considerada perdida.

A comunicação entre os dispositivos conectados via USB é feita através de um protocolo. Nele, o host, isto é, o computador ou o equipamento que recebe as conexões, emite um sinal para encontrar os dispositivos conectados e estabelece um endereço para cada um deles, lembrando que até 127 dispositivos podem ser endereçados. Uma vez estabelecida a comunicação, o host recebe a informação de que tipo de conexão o dispositivo conectado utiliza. Há quatro possibilidades:

Bulk: esse tipo é utilizado por dispositivos que lidam com grandes volumes de dados, como impressoras e scanners, por exemplo. O Bulk conta com recursos de detecção de erro para garantir a integridade das informações transmitidas;

Control: tipo utilizado para transmissão de parâmetros de controle e configuração do dispositivo;

Interrupt: tipo utilizado para dispositivos que transferem poucos dados, como mouses, teclados e joysticks;

Isochronous: esse tipo é aplicado em transmissões contínuas, onde os dados são transferidos a todo o momento, razão pela qual não há recursos de detecção de erros, já que isso atrasaria a comunicação. Dispositivos como caixas de som utilizam esse modo.

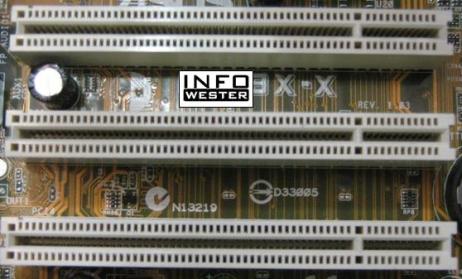

USB 1.1 e USB 2.0

Tal como ocorre com outras tecnologias, o padrão USB passa periodicamente por revisões em suas especificações para atender as necessidades atuais do mercado. A primeira versão do USB que se tornou padrão foi a 1.1. Essa versão, lançada em setembro de 1998, contém praticamente todas as características explicadas no tópico anterior, no entanto, sua velocidade de transmissão de dados não é muito alta: nas conexões mais lentas, a taxa de transmissão é de até 1,5 Mbps (Low-Speed), ou seja, de cerca de 190 KB por segundo. Por sua vez, nas conexões mais rápidas, esse valor é de até 12 Mbps (Full-Speed), cerca de 1,5 MB por segundo.

Na época do lançamento do USB 1.1, essas taxas não eram necessariamente baixas, uma vez que serviam à grande maioria dos dispositivos. No entanto, à medida que o uso do USB crescia, notou-se que também aumentava a necessidade de taxas maiores na transferência de dados. Dispositivos como scanners e câmeras digitais, por exemplo, passaram a trabalhar com resoluções mais altas, resultando em maior volume de informações.

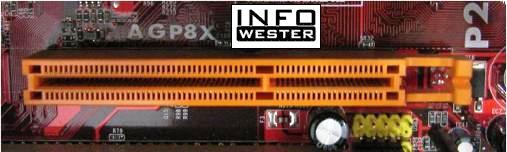

Diante desse cenário e do surgimento de tecnologias "concorrentes", em especial, o

FireWire (ou IEEE 1394), o consórcio responsável pelo USB se viu obrigado a colocar no mercado uma nova revisão da tecnologia. Surgia então em abril de 2000 o USB 2.0 (

Hi-Speed), que é o padrão de mercado até os dias de hoje (considerando a data de publicação deste artigo no InfoWester).

O USB 2.0 chegou ao mercado oferecendo a velocidade de 480 Mbps, o equivalente a cerca de 60 MB por segundo. O padrão de conexão continua sendo o mesmo da versão anterior. Além disso, o USB 2.0 é totalmente compatível com dispositivos que funcionam com o USB 1.1. No entanto, nestes casos, a velocidade da transferência de dados será a deste último, obviamente. Isso ocorre porque o barramento USB tentará se comunicar à velocidade de 480 Mbps. Se não conseguir, tentará à velocidade de 12 Mbps e, por fim, se não obter êxito, tentará se comunicar à taxa de 1,5 Mbps. Quanto à possibilidade de um aparelho USB 2.0 funcionar em conexões USB 1.1, isso pode acontecer, mas dependerá, essencialmente, do fabricante e do dispositivo.

Uma coisa que é interessante destacar em relação ao USB 2.0 é que seu lançamento trouxe também uma novidade que serviu para tornar a tecnologia ainda mais popular: a partir da versão 2.0, fabricantes puderam adotar o padrão em seus produtos sem a obrigatoriedade de pagar royalties, ou seja, sem ter que pagar licenças de uso da tecnologia.

O lançamento do USB 2.0 também trouxe outra vantagem: o padrão FireWire foi padronizado principalmente para trabalhar com aplicações que envolvem vídeo e áudio, tendo a Apple como maior apoiador. Assim, é bastante prático conectar uma câmera de vídeo por este meio. Como a velocidade do USB 2.0 supera a velocidade das primeiras implementações do FireWire (com velocidade de até 400 Mbps), o padrão também se tornou uma opção viável para aplicações de mídia, o que aumentou seu leque de utilidades. Mas, os desenvolvedores do padrão FireWire não ficaram parados e lançaram especificações novas (o FireWire 800, que trabalha à 800 Mbps). Além disso, a necessidade de velocidades cada vez maiores de transmissão de dados ainda é realidade. Por conta disso, o USB continua sendo revisado. Esse trabalho deu espaço ao USB 3.0.

USB Flash Drive, no Brasil, conhecido como Pendrive

USB Flash Drive, no Brasil, conhecido como Pendrive

USB 3.0

Ass especificações desse padrão foram definidas no final de 2008, no entanto, os primeiros produtos compatíveis com o novo padrão começaram a chegar aos consumidores no segundo semestre de 2010. Eis as principais características do USB 3.0 (SuperSpeed):

- Transmissão bidirecional de dados: até a versão 2.0, o padrão USB permite que os dados trafeguem do dispositivo A para o B e do dispositivo B para o A, mas cada um em sua vez. No padrão 3.0, o envio e a recepção de dados entre dois dispositivos pode acontecer ao mesmo tempo;

- Maior velocidade: a velocidade de transmissão de dados é de até 4,8 Gbps, equivalente a cerca de 600 MB por segundo, um valor absurdamente mais alto que os 480 Mbps do padrão USB 2.0;

- Alimentação elétrica mais potente: o padrão USB 3.0 pode oferecer maior quantidade de energia: 900 miliampéres contra 500 miliampéres do USB 2.0;

- Compatibilidade: conexões USB 3.0 poderão suportar dispositivos USB 1.1 e USB 2.0.

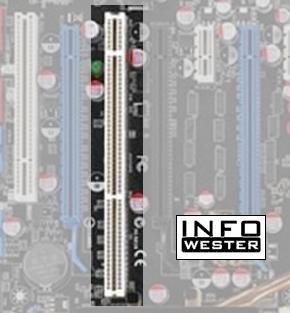

Tipos de conectores

A tecnologia USB conta com vários tipos de conectores, sendo o tipo A o mais conhecido, uma vez que está presente na maioria esmagadora dos computadores compatíveis com a tecnologia, além de poder ser encontrado em outros tipos de aparelhos. Uma vez que o objetivo principal do padrão USB é facilitar a conexão de variados dispositivos ao computador, geralmente os cabos desses aparelhos são do tipo A em uma ponta e de algum dos outros tipos na outra, podendo a segunda ponta ter também algum formato proprietário, isto é, específico de um fabricante.

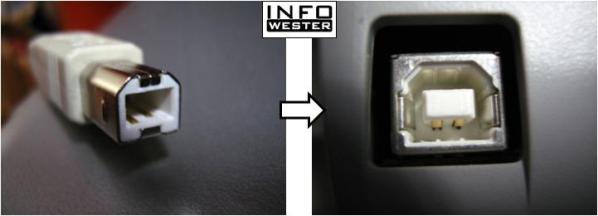

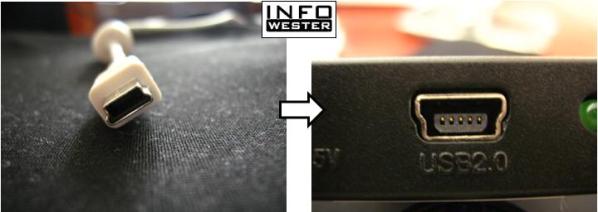

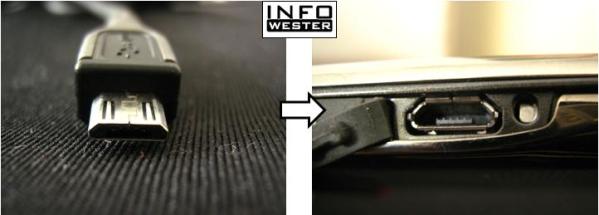

Nas imagens a seguir, os conectores (macho) estão do lado esquerdo, enquanto que seus respectivos encaixes (conectores fêmea) estão do lado direito:

USB A

É o tipo mais comum, estando presente na maioria absoluta dos computadores atuais. É também o tipo mais utilizado para os dispositivos de armazenamento de dados conhecidos como "pendrives":

USB B

Tipo comum de ser encontrado em dispositivos de porte maior, como impressoras e scanners:

Mini-USB

Utilizado em dispositivos de porte pequeno por ter tamanho reduzido, como câmeras digitais compactas e MP3-players. Na verdade, o Mini USB se chama USB Mini-B, já que existe um formato praticamente inutilizado chamado USB Mini-A. Eis os conectores Mini-USB:

Micro-USB

USB Micro-A: formato mais novo, menor que o Mini-USB, voltado a dispositivos de espessura fina, como telefones celulares:

USB Micro-B: semelhante ao formato Micro-A, no entanto, seu encaixe é ligeiramente diferente e a tendência é a de que este seja, entre ambos, o mais popular:

Vale frisar que conectores fêmeas Micro-A podem ser chamados de Micro A-B por serem compatíveis com conectores machos de ambos os tipos.

Tal como informado no início do tópico, há fabricantes que utilizam USB com conectores proprietários. O cabo abaixo, utilizado em um MP3-player da Sony, é um exemplo:

Conectores proprietários costumam não ser bem aceitos por terem custo elevado em relação a padrões de mercado e por serem mais difíceis de encontrar.

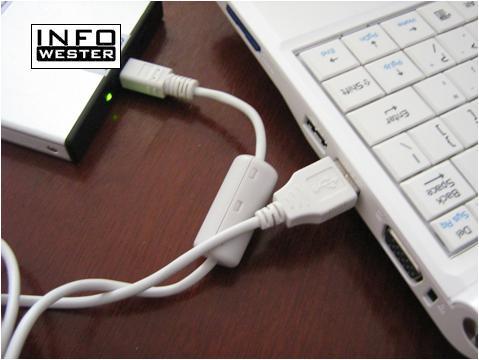

HD externo conectado em notebook via USB

HD externo conectado em notebook via USB

Finalizando

Diante de situações desse tipo, a indústria entendeu a necessidade de criar um padrão que facilitasse a conexão de dispositivos ao computador. Assim, em 1995, um conjunto de empresas - entre elas, Microsoft, Intel, NEC, IBM e Apple - formou um consórcio para estabelecer um padrão. Surgia então o USB Implementers Forum. Pouco tempo depois disso, as primeiras especificações comerciais do que ficou conhecido como Universal Serial Bus (USB) surgiram. A imagem ao lado mostra o símbolo da tecnologia.

Diante de situações desse tipo, a indústria entendeu a necessidade de criar um padrão que facilitasse a conexão de dispositivos ao computador. Assim, em 1995, um conjunto de empresas - entre elas, Microsoft, Intel, NEC, IBM e Apple - formou um consórcio para estabelecer um padrão. Surgia então o USB Implementers Forum. Pouco tempo depois disso, as primeiras especificações comerciais do que ficou conhecido como Universal Serial Bus (USB) surgiram. A imagem ao lado mostra o símbolo da tecnologia.